内部资料,请扫码登录

pigcloud

Ollama (opens new window) 是一个开源框架,专门设计用于在本地运行大型语言模型。它将模型权重、配置和数据捆绑到一个包中,优化了设置和配置细节,包括 GPU 使用情况,从而简化了在本地运行大型模型的过程。Ollama 支持多种模型,如 Llama 2、Code Llama、Mistral、Gemma 等,并允许用户根据特定需求定制和创建自己的模型。

# 安装 ollama

请注意,ollama 版本需要 0.3.0 +

-【可选】配置 ollama 对外服务 (opens new window) ,默认情况下 ollla 默认只允许本地 11434 端口访问,需要配置 ollama 对外服务。

systemctl edit ollama.service

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

systemctl daemon-reload

systemctl restart ollama

# 运行私有模型

# 聊天模型,70b 代表参数集合数量,越大越准确,但是消耗资源越多

ollama run qwen2.5:72b

# 向量模型

ollama run bge-m3:latest

请注意运行 70b 模型为生产级模型,需要 GPU 80G+ 的显存,无法在普通 CPU 条件推理,模型推理速度(可以理解为提问响应速度)取决于硬件配置。

如下图: 两块 (A6000 + 48GB)

# 模型接入

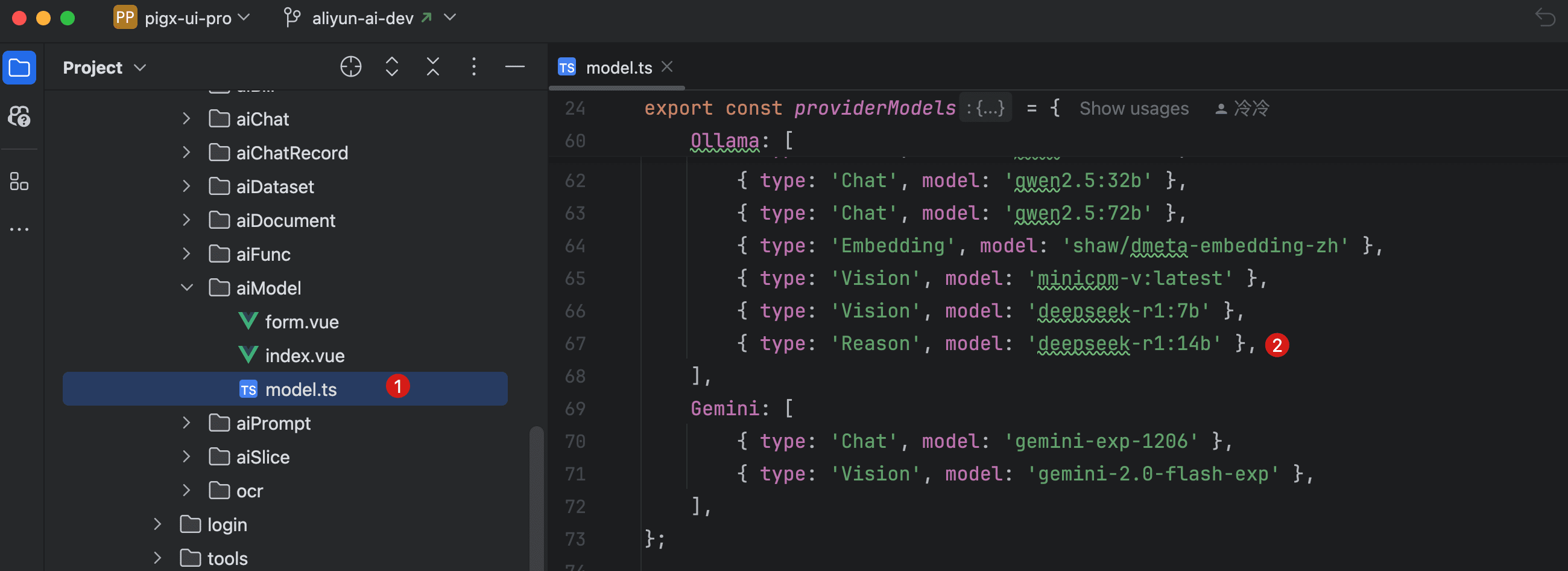

请注意配置的模型和如上 ollama 运行时模型名称一致,否则无法正常调用。

- 模型配置 > 新增模型

- 供应商:选择 Ollama

- 类型:根据需求选择聊天或推理模型

- 模型名称:选择已在 Ollama 运行的模型, 如 PIG AI 前端没有此模型选项可以输入添加